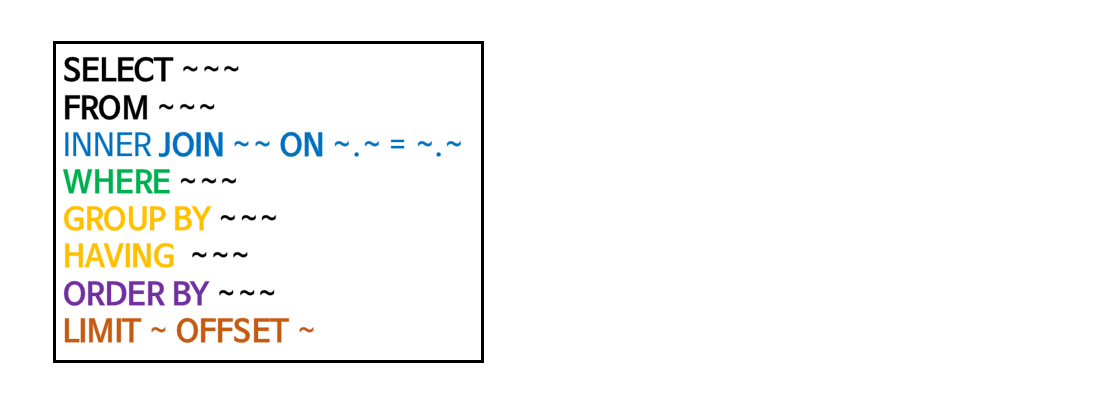

INNER JOIN #

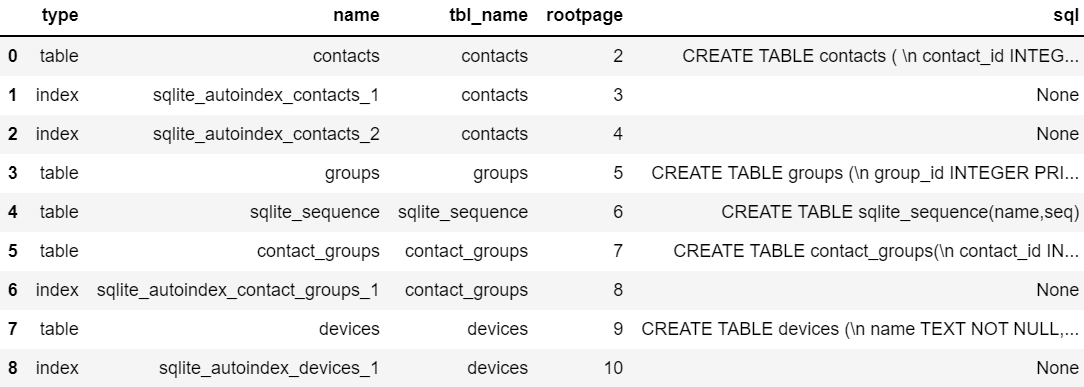

sql

SELECT

l.Title,

r.Name

FROM

albums AS l

INNER JOIN

artists AS r

ON

r.ArtistId = l.ArtistId;

sql

SELECT

Title,

Name

FROM

albums

INNER JOIN artists USING(ArtistId);LEFT JOIN #

sql

SELECT

Name,

Title

FROM

artists

LEFT JOIN albums ON artists.ArtistId = albums.ArtistId

ORDER BY

Name;SELF JOIN #

sql

SELECT m.firstname || ' ' || m.lastname AS 'Manager',

e.firstname || ' ' || e.lastname AS 'Receives reports from'

FROM

employees e

INNER JOIN

employees m

ON

m.employeeid = e.reportsto

ORDER BY

manager;- ‘A 테이블’과 A 테이블의 복사본인 ‘B 테이블’을 합치기

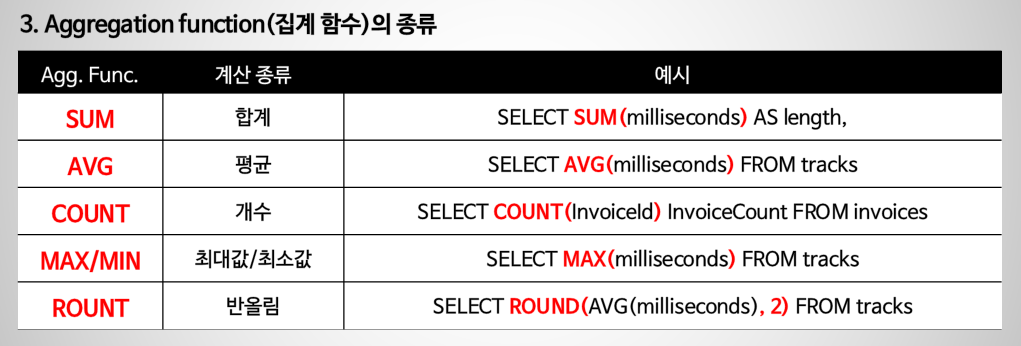

Grouping Data #